小心!人工智能开始”骗”人!仿孙子求救,有人被骗上万美元

人类科学的进步,但如果被犯罪分子利用,也意味着作案手法越来越高超。

人工智能(AI)的语音技术日渐进步,让不法分子得以随意模仿出别人的声线,骗取大众特别是长者的信任,进而冒认其亲人来诈财。

联邦贸易委员会(FTC)的数据指出,冒名诈骗成为2022年受害者第二多的骗局,当局接获超过3万6000份举报。

据《华盛顿邮报》报道,FTC表示,当中逾5100起事件属电话诈骗,涉及损失超过1100万元。

相比之下,行骗成本却低廉却得多;现时网上多的是AI语音生成工具,不法分子便是藉此从短短数句的音讯样本中复制出别人的声线,然后利用相同技术以新得来的声线“说”出任何内容。

专家表示,现时联邦监管机构、执法部门和法院对这种新兴骗局均束手无策。

大多数情况下,受害者无法辨认骗徒身份,警方也很难追踪来自世界各地的诈骗电话和资金去向。

现时也没有法律先例,要求相关网上工具的制作公司为此负责。

虽以冒名行骗的手法五花八门,但是运作方式却大同小异:骗徒冒充值得信赖的人,例如是子女、情人或朋友,并以陷入困境为由,说服受害者向他们汇款。

人工生成的语音技术让骗徒冒认别人时更有说服力,让受害者信以为真。

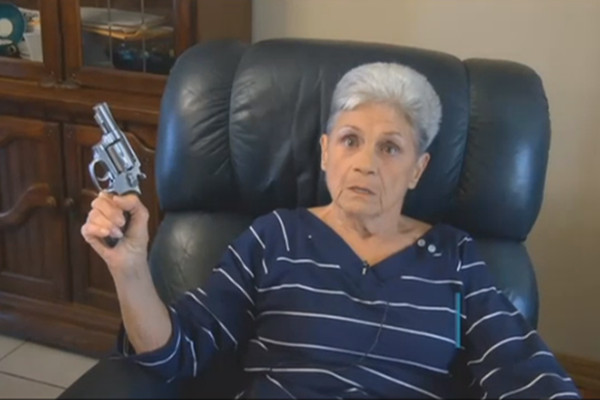

(网络配图)

专家表示,AI语音生成软体能够分析出说话者的声线特点,包括年龄、性别和口音等,然后从庞大的声音资料库中搜索出相似的声音并进行模拟预测,最后重构出整体效果非常近似的合成声线。

这项技术需要的只是一个30秒左右的音讯样本,例如是YouTube、广告、TikTok的短片音频,突破了一、两年前仍然需要大量音频来复制人声的状况。

身份盗窃资源中心(Identity Theft Resource Center)表示,执法部门很难追踪合成语音诈骗,大多是因为当局可能没有足够的资金和人力来设立专责追踪欺诈的部门。

最高法院大法官戈萨奇(Neil M. Gorsuch)2月表示,保护社交网路免受诉讼的法律保障,或许不适用于AI创造的作品。

FTC敦促民众保持警惕。

如果有亲人说需要钱,请用其他电话打给那名亲人确认。

即使来电显示是家庭成员的电话号码,那也可能是改号欺诈。

千万不要透过礼品卡方式付钱给别人,因为这种方式很难追踪,同时也要对任何现金要求保持警惕。

最后小编也想说下,科技发展到了如今,难道人与人之间又要回到靠“暗号”联络的年代了吗?